LLM劫持云基础设施的风险

关键要点

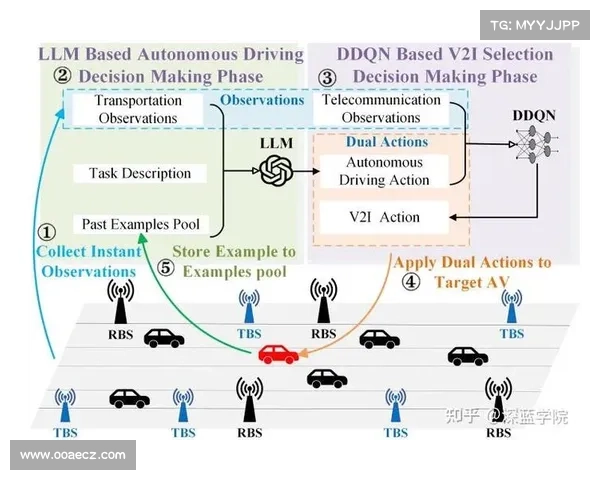

劫持云基础设施进行生成性人工智能服务是网络攻击者的新手段。攻击者通过泄露的AWS访问密钥,滥用大型语言模型LLM资源,进行不当操作。确保云环境安全的最佳实践包括使用身份联邦和多因素认证。最近,Permiso的研究人员报道,攻击者利用“LLM劫持”技术,非法使用云基础设施,运行不当聊天机器人服务,给受害者造成损失。攻击主要针对亚马逊的Bedrock环境,该环境支持基础大型语言模型LLM,如Anthropic的Claude。

Permiso在其博客中详细描述了这些攻击,并通过设置蜜罐honeypot,展示了劫持者如何利用被盗资源来运行越狱聊天机器人进行性角色扮演。

外网免费节点加速markdown 攻击目标 APIs数量 访问方式 亚马逊Bedrock 9 通过AWS Web管理控制台访问

攻击者利用在GitHub等平台泄露的AWS访问密钥,以编程方式与API端点进行通信,检查模型可用性、请求模型访问,最终使用受害者的资源来调用模型。据Permiso的帖子显示,这些API通常只通过AWS Web管理控制台访问。

AWS发言人在对SC媒体的声明中表示:“AWS服务按设计安全运行,无需客户采取行动。研究人员设计的测试场景故意忽视了安全最佳实践,以测试在特定情况下可能发生的情况,没有客户因此受到风险。”

为什么攻击者针对LLM云服务?

攻击者通过暴露的访问密钥劫持云资源,往往出于经济动机,如垃圾邮件活动和加密挖矿。在Permiso研究人员观察到攻击者逐渐开始针对Amazon Bedrock等LLM云服务后,他们建立了自己的蜜罐,以更好地理解攻击者如何利用被盗的基础设施。

Permiso研究人员在自己的亚马逊Bedrock实例上故意将访问密钥泄露在GitHub文件中以建立蜜罐。攻击者在“几分钟内”就开始尝试在蜜罐上进行活动,但标明劫持者使用LLM的行为直到初始访问密钥泄露后大约40天才有显著增加,两天内处理的提示超过75000条。

通过在蜜罐环境中启用调用日志,研究人员能够读取与LLMs之间的提示和响应,绝大多数内容显示与多种虚拟角色的性角色扮演相关。这表明劫持者利用不正当获取的基础设施运行聊天机器人服务,使用越狱手段绕过LLM的内容过滤器。其中一小部分内容涉及儿童性虐待的角色扮演。

被劫持者最常使用的模型是Anthropic的Claude 3 Sonnet。Anthropic向SC媒体表示,他们的模型无法生成图像和视频,并且输入任何儿童性虐待材料CSAM都会报告给失踪和被剥削儿童国家中心。该公司还与儿童安全倡导组织Thorn合作,测试和调整其模型,以针对与儿童诱导和虐待相关的内容进行优化。

“越狱是整个行业的关注点,我们Anthropic的团队正在积极开发新技术,让我们的模型对这些攻击更具抵抗力。我们承诺实施严格政策和先进技术来保护用户,同时发布自己的研究,以便其他人工智能开发者借鉴。我们感激研究社区在揭示潜在漏洞方面的努力,”一位Anthropic发言人说道。

在蜜罐实验期间,AWS在GitHub上自动识别并通知Permiso泄露的访问密钥,并在文件上传的同一天进行处理。几周后,AWS在2024年8月1日实施了“AWSCompromisedKeyQuarantineV2”政策;然而,Permiso指出,当时与Bedrock相关的服务并未被该政策阻止。

蜜罐账户最终于2024年8月6日被阻止使用进一步的Bedrock资源,这一决策是在劫持者的调用量达到数千的前一天。Permiso的时间线显示,AWS于2024年10月2日更新其隔离政策,包括阻止劫持者使用的多个API。

Permiso的博客帖子间接地将蜜罐活动与一个